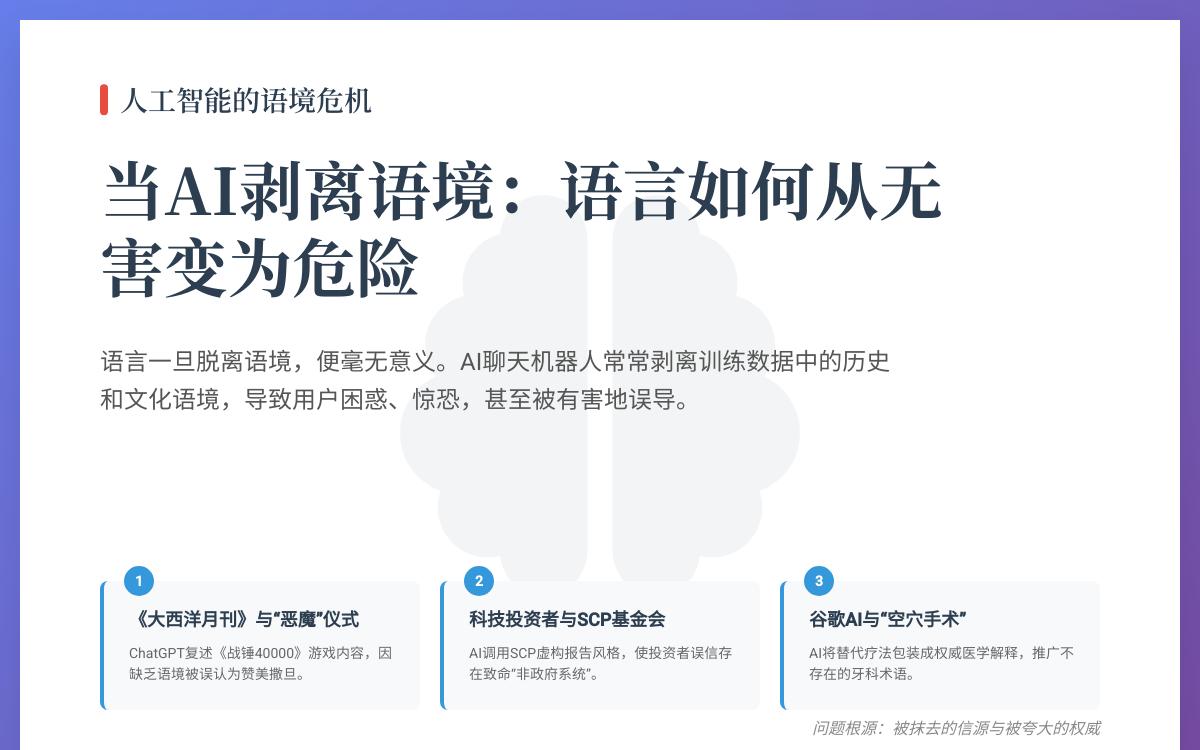

语言一旦脱离语境,便毫无意义。“我要开战了”这句话,由美国总统说出则充满不祥之兆,但由除虫专家说出则令人安心。而当前人工智能(AI)聊天机器人的核心问题在于,它们常常会剥离其训练数据中的历史和文化语境,导致用户困惑、惊恐,甚至被有害地误导。

案例一:《大西洋月刊》与“恶魔”仪式的真相

上周,《大西洋月刊》报道称,OpenAI的ChatGPT在引导记者进行一系列鼓励“各种形式自残”的仪式时,竟然赞美起了撒旦。

然而,深入探究后发现,ChatGPT并非凭空创造了这些“恶魔”内容。它实际上是在复述科幻战棋游戏**《战锤40000》(Warhammer 40,000)**中的背景故事和术语。记者们输入的关键词(如“Molech”),恰好触发了与游戏相关的训练数据。但由于AI剥离了“这是一个虚构游戏”的核心语境,导致这些原本无害的奇幻设定,在对话中显得极其险恶和恐怖。

案例二:科技投资者与SCP基金会

本月早些时候,《Garbage Day》报道了一位知名科技投资者与ChatGPT的惊人对话。这位投资者似乎相信聊天机器人告诉他的、关于一个名为“非政府系统”的实体,该实体已导致多人死亡。

据报道,这段对话的风格与一个名为SCP基金会的网络科幻写作项目极为相似。ChatGPT似乎是调用了SCP的虚构报告风格,但同样因为剥离了“这是一个集体创作的科幻故事”的语境,让这位投资者误以为自己正在与一个揭示惊天阴谋的知情者对话。

案例三:谷歌AI概览与“空穴手术”

语境缺失的问题也存在于更常见的场景。例如,当搜索一个名为“空穴手术”的医学术语时,谷歌的AI概-览会解释说它“专注于清除下颌骨中受感染或坏死的骨组织”。

然而,这个术语在美国牙科协会等权威机构中根本不存在。AI是从推广替代疗法的“整体”牙医博客中提取并整合了这些信息。它虽然提供了信息来源的链接,但通过其权威的口吻,已经将非主流、缺乏科学依据的观点,包装成了一个看似可靠的医学解释。

问题的根源:被抹去的信源与被夸大的权威

这三个案例共同指向了问题的核心:AI公司在利用我们人类的集体知识创造出强大工具的同时,却往往掩盖了这些知识的原始来源及其丰富性和复杂性。

当科技高管们宣称AI“在许多方面比人类更聪明”时,用户很容易相信AI生成的、看似权威的语言。但人类在做判断时,不仅会看信息本身,更会看信息的来源和呈现方式。AI工具恰恰抹去了这种至关重要的语境,剥夺了人们亲自审视证据并得出自己结论的机会。

未经允许不得转载:主机格调 » ChatGPT的真正“恶魔”:为何语境缺失比事实错误更危险

主机格调

主机格调