现在使用 AI 模型的场景越来越多,烈火烹油,现在高价格模型实在是太贵了,旗舰/前沿模型(如GPT-5.2、Claude Opus 4.6、Grok 4等)越来越贵,输入/输出价格动辄$1–15+/M tokens,最主要的原因是 GPU/DRAM/能源成本快速上升、AI 永动机跟不上需求的极速增长,模型规模更大、推理更复杂、以及厂商在高端定位上推高定价。

对于那些不需要高端模型的应用和服务来说,更便宜的轻量级 AI 模型已成为内容创作者、开发者、跨境电商、媒体从业者和日常高频用户尤其是对于我们这种文字处理的首选。这些模型在保持高质量的同时,强调极致速度和低成本,轻量级/高效模型(如Nano/Flash/Haiku/Fast/Mini/MoE系列)价格其实在持续下降或保持极低水平,许多已经跌到$0.03–0.20/M输入,远低于2023–2024年的水平。

轻量级 AI 模型价格为什么会下降?

- DeepSeek、Qwen、Kimi、GLM等等高性价比的中国模型在大幅降价;OpenAI/Google/xAI/Anthropic 被迫跟进推出更便宜的子模型。

- MoE(Mixture of Experts)架构、量化、蒸馏、缓存输入等让推理成本大幅降低。

- Gemma、Llama、Phi、Mistral等开源模型可免费自托管或通过低价API(如SiliconFlow、Groq、Fireworks)调用,边际成本接近0。

- 实时聊天、批量 3000 字文章处理、APP 内即时润色,都需要 TTFT(首 token 延迟)<1 秒、输出 >200 tokens/s 的模型。

- 旗舰模型(如 GPT-5 Pro、Claude Opus)动辄 $1–10/M tokens,轻量版只需 $0.03–0.30/M。

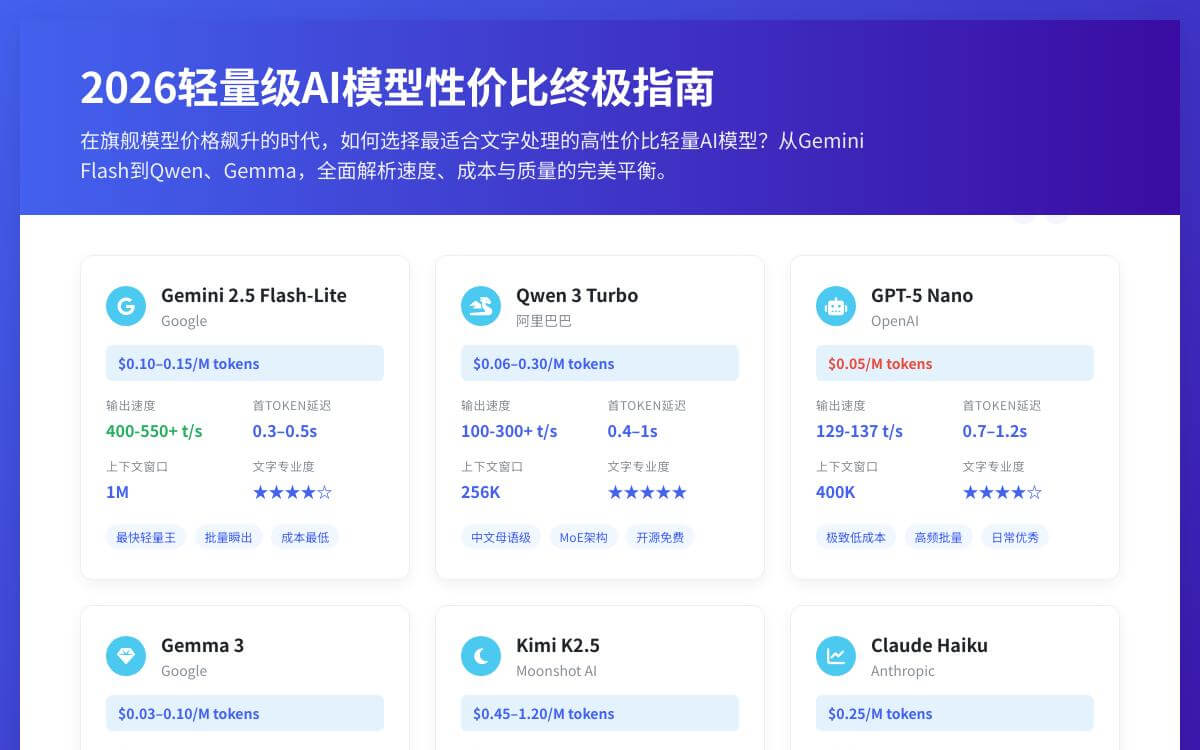

2026 年顶级轻量模型表(Non-Reasoning vs Reasoning 分开)

聚焦纯文字处理(总结、翻译、改写、润色等,适合3000字左右中长文本)。速度数据来自 Artificial Analysis、OpenRouter 等基准;专业度为综合评估(中文/多语言/逻辑/少幻觉)。

| 序号 | 模型 / 变体 (模式) | 提供商 | 输出速度 (tokens/s) | TTFT (首token延迟) | 上下文窗口 | 输入价 (/M tokens, API) | 文字专业度 (总结/翻译/润色/中文) | 最佳适用场景 & 点评 |

|---|---|---|---|---|---|---|---|---|

| 1 | Gemini 2.5 Flash-Lite (Non-Reasoning / 默认快模式) | 400–550+ (甚至更高优化) | 0.3–0.5s | 1M | $0.10–0.15 (极低) | ★★★★☆–★★★★★ (高效总结/翻译,自然流畅) | 当前最快轻量王,批量瞬出,成本最低的 Gemini 变体;适合高吞吐、无需深度思考的文字任务 | |

| 2 | Gemini 2.5 Flash-Lite (Reasoning / Thinking on-demand) | 300–450+ (稍慢但仍极快) | 0.5–1s+ | 1M | 同上 (thinking 预算可控) | ★★★★★ (开启后逻辑/准确提升) | 低成本下可切换深度推理;比默认模式质量更高,但速度牺牲少 | |

| 3 | Gemini 2.5 Flash (Non-Reasoning / 平衡快模式) | 350–500+ | 0.4–0.7s | 1M | $0.30+ (比 Lite 贵3–6x) | ★★★★★ (更聪明、全面) | 平衡速度与质量;适合需要更好理解但不想太贵的文字处理 | |

| 4 | Gemini 2.5 Flash (Reasoning / Thinking 模式) | 250–400+ | 0.6–1.5s | 1M | 同上 | ★★★★★ (顶尖推理) | 高质量总结/复杂改写首选;thinking 模式下 token 效率更高 | |

| 5 | Gemma 3 / Gemma 3n E4B (默认高效模式) | 300–500+ | 0.2–0.5s | 128K–1M | 开源免费;API ~$0.03–0.10 | ★★★★☆ (高效总结/翻译) | 最便宜+最快开源,轻量爆表,适合批量/本地 | |

| 6 | Nova Micro / Nemotron Nano (默认快模式) | NVIDIA | 300–450+ | 0.18–0.4s | 128K | 低(优化平台) | ★★★★☆ (技术/科学文字优秀) | 延迟最低,硬件优化神,实时分类/提取 |

| 7 | Mistral Nemo / Small 3 (默认快模式) | Mistral AI | 250–450+ | 0.4–0.8s | 128K–256K | ~$0.15–0.30;开源免费 | ★★★★☆–★★★★★ (多语言润色流畅) | 欧洲开源王者,边缘部署友好 |

| 8 | Claude Haiku (3/4) (默认 / 无重 reasoning) | Anthropic | 200–300+ | ~0.5s | 200K | ~$0.25 | ★★★★★ (语感/准确顶尖) | 专业润色/翻译首选,少幻觉 |

| 9 | Qwen 3 / Qwen2.5-Turbo (轻量MoE, 默认快模式) | Alibaba | 100–300+ | 0.4–1s | 128K–256K | ~$0.06–0.30;开源免费 | ★★★★★ (中文母语级) | 中文文字处理最强,MoE变体速度极快 |

| 10 | Kimi K2.5 (Non-Thinking / 非thinking模式) | Moonshot AI | 200–340+ | ~0.5–1s | 256K | ~$0.45–1.20 | ★★★★★ (中文/逻辑严谨) | 深度中文研究/报告,非thinking 快 |

| 11 | Kimi K2.5 (Thinking 模式) | Moonshot AI | 150–280+ | 1s+ | 256K | 同上 | ★★★★★ (更深逻辑) | 长文总结/复杂分析,质量更高但慢 |

| 12 | DeepSeek V3 / V3.2 (Non-Reasoning / 默认) | DeepSeek | 60–250+ (优化后) | ~0.5–2s | 128K–164K | $0.27–0.30 | ★★★★☆–★★★★★ (技术/学术强) | 性价比王,批量技术文档 |

| 13 | DeepSeek V3 / V3.2 (Reasoning 模式) | DeepSeek | 较低 (视优化) | 更高 | 同上 | 同上 | ★★★★★ (深度任务) | 复杂文字推理时用 |

| 14 | GLM-4.7 / GLM-4.5V (默认快模式) | Z.ai / 智谱 | 180–350+ | ~0.5–1s | 200K+ | ~$0.20–0.50 | ★★★★★ (中文/规划强) | 中国开源新星,长文稳 |

| 15 | Phi-3.5 / Phi-4 Mini (默认高效) | Microsoft | 200–400+ | 0.3–0.6s | 128K | 开源免费;API ~$0.10 | ★★★★☆ (英语/代码顶尖) | 小模型推理最强,on-device |

| 16 | GPT-5 Nano (默认 / 无强 reasoning) | OpenAI | 129–137 | 0.7–1.2s | 400K | $0.05 | ★★★★☆ (日常优秀) | 极致低成本+快,高频批量 |

| 17 | Grok 4.1 Fast (Non-Reasoning 模式) | xAI | 106–118 | ~0.75s | 2M | $0.20 | ★★★★☆ (长文/工具强) | 超大上下文,纯文字快响应 |

| 18 | Grok 4.1 Fast (Reasoning 模式) | xAI | 较低 (思考开销) | 几秒到10+s | 2M | 同上 | ★★★★★ (agent/复杂任务顶尖) | 多步逻辑/深度研究,长文神器但慢 |

| 19 | Llama 4 Scout / Maverick (轻量MoE, 默认) | Meta | 150–400+ (优化后) | 0.3–0.8s | 10M (Scout) / 128K–1M | 开源免费;API ~$0.06–0.20 | ★★★★☆ (多语言好,长文稳) | 超长文档王,开源自托管 |

不同场景选择不同的轻量模型

- 追求极致速度 + 批量处理(瞬出 3000 字总结/翻译):GPT-5 Nano、Gemini 2.5 Flash-Lite (Non-Reasoning)、 Gemma 3

- 中文内容为主(润色、翻译、SEO 文案):Qwen 3、Kimi K2.5 (Non-Thinking)、GLM-4.7

- 成本最低 + 高频使用、GPT-5 Nano、Gemma 3(开源免费)

- 偶尔需要深度推理(复杂报告改写、逻辑分析):Gemini Flash (Reasoning) 、 Grok 4.1 Fast (Reasoning)

- 开源/本地部署:Gemma 3、Llama 4 Scout、Mistral Nemo、Phi-4 Mini

如果每天处理大量中文 3000 字文章,Qwen 3 或 Kimi K2.5 Non-Thinking 是目前性价比与专业度的双王者;追求全球最快响应;Gemini 2.5 Flash-Lite 几乎无敌;预算极致紧,GPT-5 Nano 或开源 Gemma 3 能让你省下大笔钱。

高性价比的轻量级 AI 模型问题FAQ

Q:为什么旗舰 AI 模型(如 GPT-5、Claude Opus、Grok 4)越来越贵?

A:核心原因在于 GPU、DRAM 和能源成本持续上升,而 AI 推理需求的增长速度远超算力扩张。同时模型参数规模更大、推理链路更复杂,厂商也通过高端定位刻意拉开产品价格区间,最终导致旗舰模型输入和输出价格长期维持在高位。

Q:哪些使用场景其实并不需要高端 AI 模型?

A:文章总结、翻译、改写、润色、SEO 文案、批量文本提取等场景,对复杂推理能力依赖不高,使用旗舰模型往往属于性能过剩,反而增加长期使用成本。

Q:什么是轻量级 AI 模型?

A:轻量级 AI 模型通常指 Nano、Flash、Haiku、Fast、Mini、MoE 等变体,特点是首 token 延迟低、输出速度快、调用成本极低,专为高频文本处理而设计,而非复杂多步推理。

Q:为什么轻量级 AI 模型的价格会持续下降?

A:一方面,DeepSeek、Qwen、Kimi、GLM 等高性价比模型主动降价,推动市场竞争;另一方面,MoE 架构、量化、蒸馏和缓存等技术显著降低了推理成本,加上 Gemma、Llama、Mistral、Phi 等开源模型的普及,整体价格被不断压低。

Q:轻量级 AI 模型会不会牺牲输出质量?

A:在总结、翻译、改写、润色等文字任务中,大多数轻量模型已经可以稳定输出自然、连贯且少幻觉的结果,与早期旗舰模型差距并不明显,主要差异集中在复杂推理能力上。

Q:处理 3000 字左右的文章,轻量模型够用吗?

A:完全够用。3000 字级别的文本处理更依赖首 token 延迟、整体输出速度和语言稳定性,而这些正是轻量级 AI 模型最擅长的区间。

Q:什么是 TTFT(首 token 延迟),为什么这么重要?

A:TTFT 指模型返回第一个 token 所需的时间,它直接决定用户的体感响应速度。在实时聊天、APP 内即时润色和批量处理场景中,TTFT 往往比最终生成速度更影响体验。

Q:中文内容处理,哪些轻量模型表现最好?

A:Qwen、Kimi、DeepSeek、GLM 等模型在中文总结、翻译准确度和语感自然度方面表现突出,更符合中文母语使用习惯。

Q:哪些轻量级 AI 模型在速度上最有优势?

A:在纯文字处理场景中,Gemini 2.5 Flash-Lite、Gemma 3、GPT-5 Nano 等模型以极低延迟和高 tokens/s 输出表现领先,适合高吞吐和批量任务。

Q:什么时候才需要开启 Reasoning 或 Thinking 模式?

A:当任务涉及复杂逻辑推导、多步骤分析、研究型写作或 Agent 协作时才有必要开启 Reasoning;日常文本处理使用 Non-Reasoning 模式通常更快、更省钱。

Q:开源轻量模型适合普通用户和内容创作者吗?

A:非常适合。开源模型支持本地部署和私有化使用,长期边际成本极低,特别适合高频文本处理、内容生产和企业内部系统。

Q:如果每天处理大量中文 3000 字文章,如何选择最省钱?

A:优先选择中文能力强、非 Thinking 的轻量模型,例如 Qwen 或 Kimi;如果更追求响应速度,可选择 Gemini 2.5 Flash-Lite;在预算极度敏感的情况下,GPT-5 Nano 或开源 Gemma 3 是成本最低的方案。

Q:未来轻量级 AI 模型的价格还会继续下降吗?

A:在轻量模型领域,价格大概率会维持低位甚至继续下探;而旗舰模型受算力、能耗和定位影响,长期仍将保持明显溢价。

未经允许不得转载:主机格调 » AI 模型太贵用不起?2026 年速度快价格便宜的轻量级 AI 模型推荐,低至 $0.03/M

主机格调

主机格调